|

|

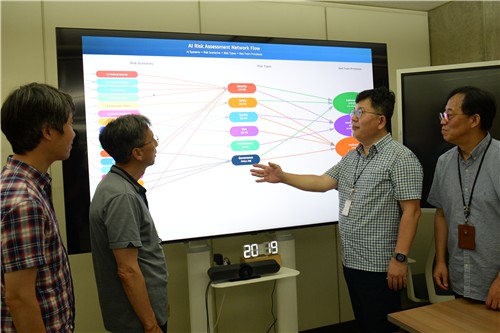

AI 레드팀 테스팅은 생성형 AI가 잘못된 정보를 내놓거나 사용자 보호장치를 피해 악용되는 상황을 찾아내기 위해 시스템이 얼마나 안전한지를 공격적으로 탐색하며 테스트하는 방법이다.

연구원은 이 분야의 국제표준인 'ISO·IEC 42119-7'의 에디터 역할을 맡아 의료·금융·국방 등 분야에 공통으로 적용할 수 있는 국제 공통 시험 절차와 방법을 만들고 있다.

STA·네이버·업스테이지·셀렉트스타·KT·LG AI연구원 등 주요 기업과 협의체를 구성해 AI 레드팀 국제표준화 협력도 강화하고 있다.

신뢰성 사실 라벨은 AI 시스템이 얼마나 신뢰할 수 있는지를 한눈에 알 수 있도록 시각화한 것으로, ETRI는 'ISO·IEC 42117' 시리즈 표준 개발을 주도하고 있다.

이승윤 표준연구본부장은 "AI 안전과 신뢰성 분야의 국제표준화를 통해 단순한 기술력 확보를 넘어 AI 시대 규칙을 만드는 선도자 역할을 해 나가겠다"고 말했다.

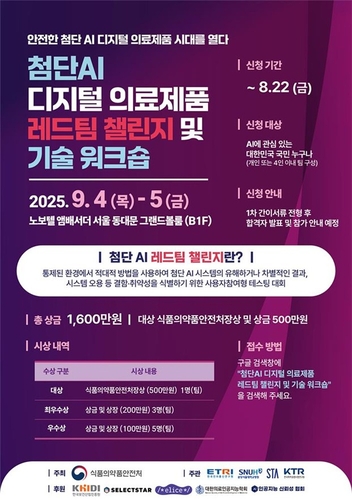

한편 ETRI는 식품의약품안전처와 공동으로 내달 4∼5일 노보텔 앰배서더 서울 동대문호텔에서 '첨단 AI 디지털의료제품 레드팀 챌린지와 기술 워크숍'을 연다. 인공지능 의료기기 분야에서는 국내 최초로 열리는 행사로, 의료인·보안전문가 등이 참여해 AI의 편향, 위험성 등을 점검한다.

jyoung@yna.co.kr

<연합뉴스>